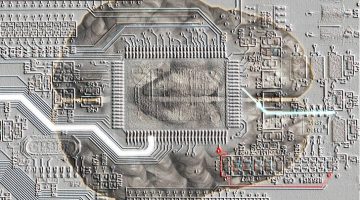

OpenAI’s AI Models Are Now More Persuasive Than Most Reddit Users – Fonte dell’immagine: ChatGPT-4o

Una delle principali sfide nell’uso dell’intelligenza artificiale è che i loro utenti tendono spesso a fare affidamento su processi automatizzati. Gli algoritmi oggi dominano la nostra quotidianità sempre più iper-connessa e funzionano spesso e possono essere usati come armi di condizionamento di massa, capaci di profilare gli utenti e modulare contenuti e messaggi per persuadere, influenzare e manipolare opinioni e comportamenti.

L’IA, insieme ai social media, amplifica la persuasione occulta già esistetnte da decenni (radio, Tv, mainstream,,,) rendendo la manipolazione ancora più opaca e pervasiva, perché i processi decisionali dell’IA sono percepiti come neutrali, mentre invece incorporano pregiudizi e strategie psicologiche sofisticate.

Rispetto ai media tradizionali come radio, TV e pubblicità, l’IA aggiunge una dimensione di automazione e scalabilità senza precedenti, rendendo possibile una manipolazione di massa su larga scala, più mirata e meno riconoscibile. L’evoluzione delle tecnologie persuasive ha raggiunto una nuova frontiera con l’avvento dell’intelligenza artificiale.

La pagina di Amnesty riassume piuttosto bene.

Se volete essere aggiornati sulle ultime novità, iscrivetevi al CANALE TELEGRAM https://t.me/NogeoingegneriaNews

Pericolosamente utile: come l’intelligenza artificiale minaccia i nostri diritti umani

“Riempimi insieme in quattro frasi!”, “Scrivi cinque suggerimenti per questo testo!” “Crea una presentazione sul tema delle balene!” – I procuciti di ChatGPT sono diventati la vita di tutti i giorni per molte persone. Il popolare chatbot è probabilmente l’esempio più noto dell’uso quotidiano dell’intelligenza artificiale (AI). Oggi, tuttavia, l’IA è diventata parte della nostra vita quotidiana in molte altre aree, ad esempio nei sistemi di navigazione in auto, nella casa intelligente o nei dispositivi medici. Le nuove tecnologie si sono rapidamente affermate. Oltre a molti usi utili, tuttavia, l’intelligenza artificiale pone rischi massicci: il monitoraggio, la discriminazione e persino i pericoli mortali dell’uso automatico delle armi sono l’altro lato oscuro della medaglia AI. Ecco perché è fondamentale comprendere bene i sistemi di IA per quanto riguarda i nostri diritti umani e perseguire un approccio basato sui diritti umani. Puoi scoprire cosa sta succedendo e quali rischi abbiamo urgente bisogno per proteggerci in questa pagina.

I tre termini principali: Cosa sono l’IA, l’IA generativa e gli algoritmi?

Discriminazione, manipolazione e attacchi alla privacy: quali pericoli comportano l’AI?

Opportunità: in che modo l’intelligenza artificiale può sostenere l’impegno per i diritti umani?

IA e diritti umani: le richieste di Amnesty International

Quali sistemi di IA devono vietare per proteggere i diritti umani?

Glossario: Glossario e definizione di AI

I tre termini più importanti: cosa sono l’IA, l’IA generativa e gli algoritmi?

L’intelligenza artificiale (AI) si riferisce alla simulazione dell’intelligenza umana nelle macchine o. I programmi per computer. Ciò consente ai programmi di completare compiti che normalmente richiedono intelligenza umana. Questi includono, ad es. Soluzioni problematiche, apprendimento, riconoscimento vocale e traduzione, percezione visiva e processo decisionale. L’intelligenza artificiale è utilizzata in un’ampia varietà di settori, come l’assistenza sanitaria, la finanza, la sorveglianza, l’istruzione o l’intrattenimento.

L’intelligenza artificiale generativa (GAI) è un sottoinsieme dell’IA che si concentra sulla creazione autonoma di nuovi contenuti come immagini, testo, musica o codici informatici. GAI può generare una varietà di risultati basati su set di dati completi. Esempi ben noti di Intelligenza Artificiale Generativa sono ChatGPT, Dall-E o Midjourney. Mentre questi strumenti sono utili per la creazione di contenuti, c’è anche il rischio di un uso improprio creando falsi profondi. Inoltre, sorgono problemi di copyright per quanto riguarda i dati utilizzati per la formazione del GAI.

Un algoritmo è un insieme di istruzioni o regole che un programma per computer segue per eseguire determinate attività o per risolvere un problema. Queste istruzioni devono essere fatte nell’ordine corretto, paragonabile a una ricetta di cottura.

Discriminazione, manipolazione e attacchi alla privacy: quali pericoli comportano i diritti umani con l’IA?

Discriminazione da parte dei sistemi di IA

I pregiudizi (noti anche in questo contesto sotto il termine distorsione inglese), che sono incorporati negli algoritmi e nei sistemi di intelligenza artificiale durante la programmazione o in formazione, possono portare a discriminazione. I dati vengono spesso utilizzati anche per addestrare i sistemi di intelligenza artificiale che sono già discriminanti su o I bias includono, ad esempio, in termini di colore della pelle o di genere.(ndr ma sopratutto a riguardo di certe tematiche) Ciò significa che la discriminazione esistente viene riprodotta o addirittura rafforzata.

Una delle principali sfide nell’uso dell’intelligenza artificiale è che i loro utenti di solito tendono a fare affidamento su processi automatizzati. Spesso le persone valutano i sistemi AI e ADM (sistemi decisionali algoritmici) come neutrali, affidabili e affidabili. Pertanto, tendono ad attribuire maggiore importanza a questi sistemi rispetto ad altre fonti e fondamentali. Ciò può portare a errori nel processo decisionale e al fatto che il pregiudizio è adottato nel sistema senza dubbio.

Negli ultimi anni, ci sono stati un aumento dei casi di utilizzo di strumenti di riconoscimento facciale che hanno portato a falsi arresti. Ciò ha particolarmente colpito le persone con colore della pelle non bianco, poiché il software di riconoscimento facciale ha identificato in modo sproporzionato le persone con colore della pelle non bianco.

Anche nei loro sistemi di sicurezza sociale gli Stati utilizzano sempre più le tecnologie digitali. Gli Stati presentano spesso sistemi come una soluzione neutrale o tecnocratica progettata per migliorare l’amministrazione, riconoscere le frodi e aumentare la sicurezza. Ricerche approfondite mostrano che la digitalizzazione nella gestione dei servizi di supporto sociale pone molti rischi per il diritto umano alla sicurezza sociale e può esacerbare la disuguaglianza. Ad esempio, uno che l’introduzione del processo decisionale semiautomatico nell’esame del diritto alle prestazioni sociali riguardava la maggior parte di alcuni dei gruppi più emarginati di persone. La situazione è anche simile nella minaccia al nostro diritto alla salute: nel recente passato, sempre più organismi statali e privati stanno iniziando a utilizzare sistemi supportati dall’IA o controllati dall’intelligenza artificiale, la cui base è spesso discutibile o difettosa e il cui algoritmo si basa esclusivamente su un valore medio, ma non risponde alle esigenze specifiche delle persone interessate. Le decisioni che ne derivano possono avere un impatto enorme sulla situazione sanitaria e finanziaria delle persone colpite.

Per gli esempi vedi la pagina

Deep fakes e manipolazione

Gli algoritmi basati sull’intelligenza artificiale su grandi piattaforme online sono spesso progettati per massimizzare le azioni degli utenti. Ciò rafforza l’emergere di camere di eco che hanno un chiaro effetto sulle procedure democratiche e sulle libertà personali. La manipolazione dell’opinione pubblica è favorita, la nostra opportunità di impegnarsi con una vasta gamma di opinioni ridotte. La soppressione del dissenso limita anche il diritto alla libertà di espressione e il diritto di accesso alle informazioni.

Lo scandalo che circonda la società di analisi dei dati Cambridge Analytica ha dimostrato quanto facilmente i dati personali possano essere utilizzati in modo inaspettato per la manipolazione e l’influenza. Tale abuso di tecnologia non solo viola il principio della libertà di espressione, ma anche il diritto alla privacy e ha un impatto enorme sulla nostra società.

I deep fakes generati con l’intelligenza artificiale generativa – sotto forma di immagini, video o applicazioni audio – possono manipolare l’opinione pubblica, calunniare gli oppositori e distruggere la reputazione delle persone. Nel gennaio 2024, ad esempio, una chiamata generata con l’aiuto dell’intelligenza artificiale nel New Hampshire in occasione delle primarie mentre il presidente degli Stati Uniti Joe Biden lo ha emesso e ha invitato gli elettori a rimanere a casa.

Rilevamento delle emozioni, sorveglianza di massa e altre distopie

I governi di tutto il mondo utilizzano sempre più le tecnologie biometriche – dal riconoscimento facciale al linguaggio del corpo al riconoscimento delle emozioni – e minacciano i nostri diritti umani. Rafforzano la discriminazione sistematica, che di solito è diretta contro i gruppi già emarginati.

Con il pretesto della “sicurezza nazionale”, i sistemi di riconoscimento facciale sono utilizzati dai governi per monitorare eccessivamente gli individui. Le forze dell’ordine utilizzano questi sistemi nello spazio pubblico per identificare le persone che potrebbero aver commesso o che credono di poter commettere potenzialmente un crimine

La sorveglianza può avere un cosiddetto “effetto agghiacciante”, il che significa che le persone evitano di esercitare il proprio diritto perché presumono che saranno monitorati. Ciò significa che possono esserci anche violazioni del diritto alla libertà di riunione o La libertà di espressione.

Per molti anni Amnesty International si è impegnata a vietare completamente la sorveglianza biometrica nello spazio pubblico da parte di attori statali e privati.

Con il pretesto di garantire una maggiore sicurezza, ci sono state ripetutamente idee e programmi di ricerca non messi in scena per l’uso dell’intelligenza artificiale in passato, che avrebbero avuto una scala orwelliana e avrebbero significato una sorveglianza continua. Ad esempio, è stato pianificato il cosiddetto programma “INDETTO”: nell’ambito di questo programma di ricerca dell’UE, è stata pianificata la fusione di dati e registrazioni video già archiviati con dati personali provenienti dai social network. Un motore di ricerca dovrebbe cercare continuamente siti Web o forum disponibili pubblicamente e essere combinato con le tecnologie di riconoscimento facciale e le registrazioni delle telecamere di sorveglianza, nonché i dati dei social media per prevedere le attività criminali.

Approccio basato sui diritti umani: cosa chiede Amnesty International?

Tutti i diritti umani sono influenzati dagli sviluppi dell’intelligenza artificiale. Pertanto, è nello sviluppo di AI, GAI o Strumenti di intelligenza artificiale di fondamentale importanza per adottare un approccio basato sui diritti umani. Ciò significa che progettare, implementare, fornire e utilizzare le tecnologie di IA deve essere coerente con i principi fondamentali dei diritti umani e proteggere le nostre libertà e i nostri diritti. Questo ci permette di sfruttare al minimo le potenzialità di queste tecnologie riducendo al contempo i rischi connessi.

I diritti umani devono essere al centro dell’attenzione dallo sviluppo all’uso dell’IA! Amnesty International chiede di tener conto e di attuare i seguenti punti:

Garantire la massima trasparenza e comprensibilità circa l’uso dell’IA, in modo che l’impatto sia comprensibile e verificabile per le persone fisiche e le autorità di vigilanza.

Due diligence dei diritti umani e valutazioni d’impatto obbligatorie, sia per gli sviluppatori che per gli utenti che utilizzano l’intelligenza artificiale.

Criteri adeguatamente chiari per la classificazione dei rischi dei sistemi di IA e la creazione di meccanismi che consentano l’aggiornamento e l’integrazione di tali categorie.

Meccanismi di controllo efficaci e indipendenti.

Un divieto più completo di sorveglianza biometrica nello spazio pubblico da parte di attori statali e privati.

Un divieto di utilizzo dei dati biometrici per altri scopi, come il riconoscimento delle emozioni o altri sistemi di categorizzazione biometrica.

Un divieto di qualsiasi manipolazione nascosta e condizionamento per mezzo di AI.

Una severa regolamentazione dei sistemi di IA che hanno un alto rischio di violazioni dei diritti umani

Un divieto di sviluppo, produzione, vendita e utilizzo di tecnologie biometriche che consentano la sorveglianza di massa e una sorveglianza mirata discriminatoria, sia per gli attori pubblici che privati.

Un divieto di sviluppo, produzione, vendita e utilizzo di sistemi di intelligenza artificiale che creano o estendono i database per il riconoscimento facciale attraverso la lettura non mirata di immagini facciali da Internet o da registrazioni video.

Un divieto di esportazione di sistemi di IA vietati nell’UE.

Coinvolgere e rafforzare le persone e le comunità. Rimedi e meccanismi di reclamo per individui, gruppi e organizzazioni senza scopo di lucro che sono stati danneggiati dall’IA.

Quali sistemi di IA devono essere vietati per proteggere i diritti umani?

Amnesty International chiede un divieto sui sistemi di IA che rappresentino un rischio inaccettabile per i diritti umani delle persone e delle comunità. Alcune applicazioni di IA sono fondamentalmente incompatibili con i diritti umani o rappresentano sempre un rischio inaccettabile. Amnesty International si impegna a vietarlo. Questi includono:

Tecnologia di riconoscimento facciale per il monitoraggio degli spazi pubblici e di altre forme di sorveglianza biometrica.

Utilizzo di sistemi di rilevamento delle emozioni.

Social scoring (monitoraggio e valutazione del comportamento personale per decidere su aree quali solvibilità, occupazione o stato sociale).

Sistemi d’arma autonomi che decidono la vita e la morte.

Polizia predittiva (il tentativo di prevedere i crimini).

Uso dei sistemi di intelligenza artificiale da parte delle forze dell’ordine e delle autorità di giustizia penale.

Applicazioni di IA che discriminano le persone in fuga e contribuiscono ai respingimenti illegali.

Traduzione automatica del sito

DALLA PERSUASION OCCULTA ALLA IPER-PERSUASIONE – IL LAVAGGIO DI CERVELLO PERFEZIONATO?

IMPORTANTE!: Il materiale presente in questo sito (ove non ci siano avvisi particolari) può essere copiato e redistribuito, purché venga citata la fonte. NoGeoingegneria non si assume alcuna responsabilità per gli articoli e il materiale ripubblicato.Questo blog non rappresenta una testata giornalistica in quanto viene aggiornato senza alcuna periodicità. Non può pertanto considerarsi un prodotto editoriale ai sensi della legge n. 62 del 7.03.2001.